Der dritte Tag ist jetzt auch geschafft.

Die größte Herausforderung heute war die Datenvorbereitung. Wir mussten Daten von einer Wetter-API abrufen und damit ein Dashboard erstellen. Die Schwierigkeit bestand darin, dass die benötigten Daten nur auf der niedrigsten Ebene der API verfügbar waren, nämlich auf Stadtebene.

Zuvor mussten wir jedoch herausfinden, welche Länder überhaupt verfügbar sind, dann welche Bundesstaaten in jedem Land zu finden sind, und erst dann konnten wir die Daten für jede Stadt abrufen. Vorausgesetzt, man wusste, in welchem Bundesstaat die Stadt liegt. Zum Beispiel gibt die API an, dass Rom in Latium liegt, was keinen Sinn macht. Daher war es sehr schwierig, die Daten von dieser API zu erhalten.

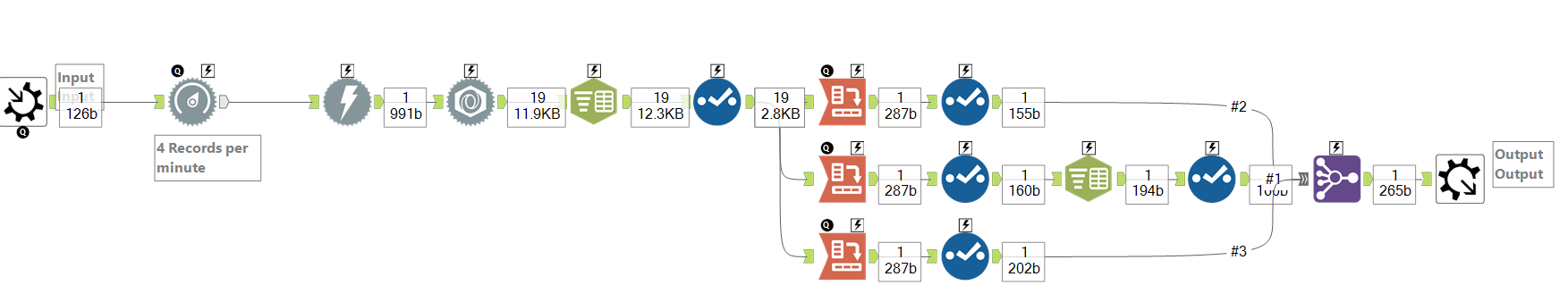

Deshalb habe ich mich entschieden, nur die Daten für bestimmte Städte zu finden, um damit eine Präsentation zu erstellen. Mein Workflow sah dann so aus:

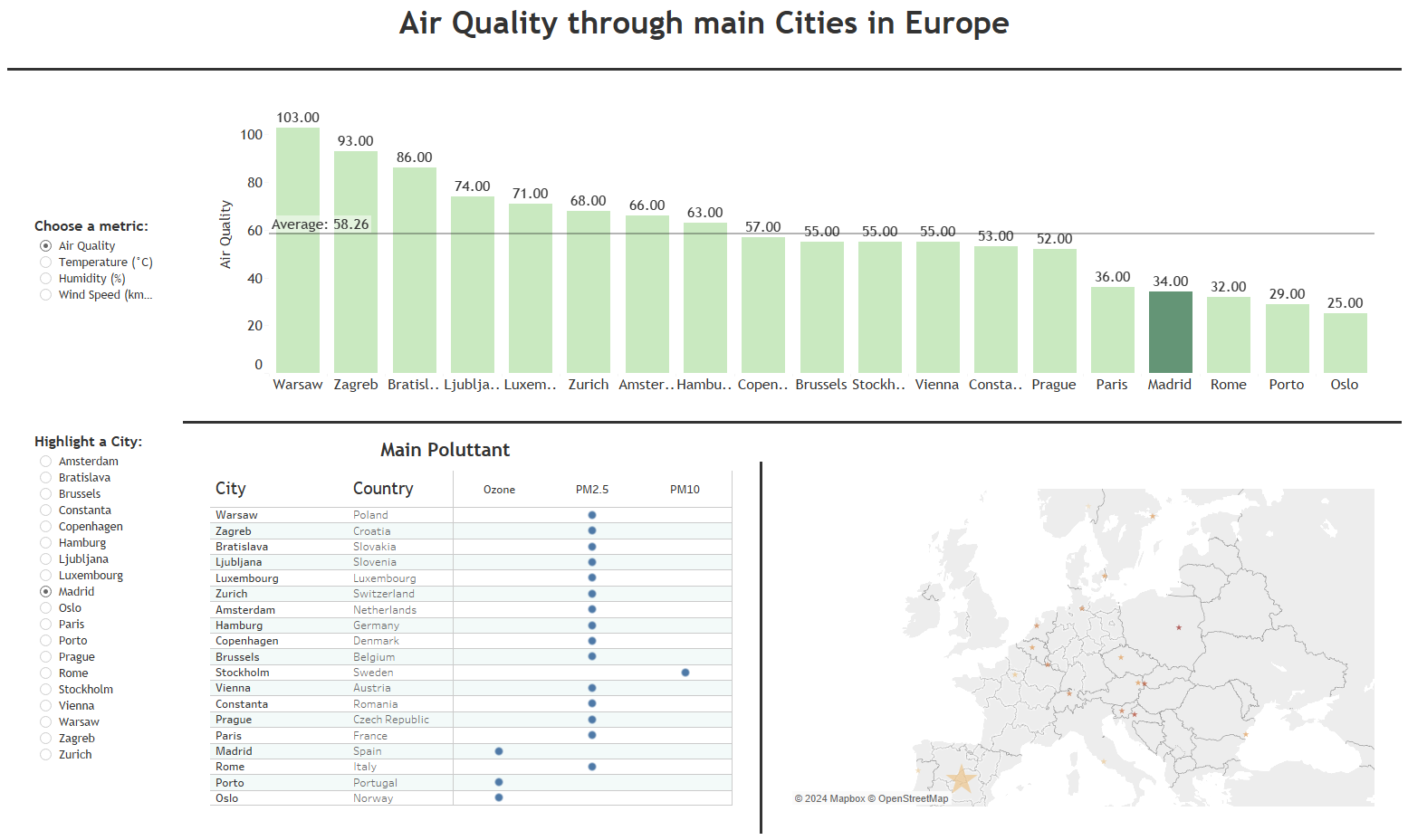

Nachdem ich die Daten in einer .hyper-Datei gespeichert hatte, konnte ich mit Tableau arbeiten. Hier stellte sich die nächste Herausforderung heraus. Da die API-Daten nur für den aktuellen Tag verfügbar waren, war eine zeitliche Analyse nicht möglich. Daher habe ich mich entschieden, ein Balkendiagramm zu erstellen, das dynamisch nach bestimmten Metriken sortiert werden kann.

Danach habe ich eine Tabelle erstellt, um zu zeigen, dass PM2.5 (Feinstaub mit einer Partikelgröße von 2,5 Mikrometern) der größte Faktor für Luftverschmutzung in Europa ist.

Am Ende sah mein Dashboard so aus:

Nach diesem Tag kann ich sagen, dass es gut war, wieder mit Alteryx die Daten vorzubereiten, und ich freue mich, dass ich fast alle benötigten Daten erhalten habe. Allerdings war die API teilweise ziemlich frustrierend, und ich wünschte, ich hätte mehr Zeit investiert, um die Struktur besser zu verstehen.